ARGENTINA

4 de junio de 2024

Alerta Grooming: preocupa la generación con IA de imágenes ficticias de adolescentes desnudos

Con el avance de la Inteligencia Artificial, los predadores sexuales encuentran un peligroso aliado para generar imágenes realistas de menores de edad. En Buenos Aires, cuatro adolescentes lo hicieron con una compañera y la víctima hasta llegó a dudar de si ella se había tomado la foto.

Ya no es simplemente un riesgo inminente, sino que -en algunos casos- se ha convertido en episodios concretos, con nombres y apellidos. En algunos colegios de la Provincia de Buenos Aires, adolescentes han recurrido a la Inteligencia Artificial para “desnudar” a sus compañeras.

En uno de estos casos puntuales, y a través de esta herramienta tecnológica -cada vez más en auge-, cuatro adolescentes modificaron una foto real de una de sus compañeras y, con la cara real de la chica, la usaron en la foto de una adolescente desnuda.

“La chica llegó a dudar de sí misma cuando vio la foto, y hasta revisó su galería en el celular para ver si efectivamente se había tomado ella la foto. Pero es una foto que nunca sacó”, describe el presidente de la ONG Grooming Argentina y de la red Grooming Latam, Hernán Navarro.

El hecho de que la víctima haya llegado a dudar de sí misma y de la autenticidad de la foto no hace más que confirmar que el riesgo es real, y la IA es una amenaza ya tangible. Porque, a través del Deep Fake (como se conoce a estas fotografías ficticias y asombrosamente realistas), la Inteligencia Artificial ya es un peligro y un aliado perfecto para los groomers (autores del delito de Grooming, que se traduce como ciber acoso sexual).

“La tecnología en sí, bien utilizada, es muy beneficiosa. Pero mal utilizada podría generar perjuicios, por eso siempre hay que trabajar sobre el equilibrio, ya que puede ser una gran amiga o una gran enemiga”, se explaya Navarro.

“Con la IA pasa lo mismo, es una gran herramienta, aunque analizándola estrictamente desde la visión de las redes criminales, podrían encontrar en esta herramienta la instancia de cambio de paradigma. No solo en el Grooming, sino en la pedofilia”, agrega el abogado especializado en el tema.

Si bien hasta hace pocos meses se necesitaba de un instante de vulnerabilidad en los niños, niñas y/o adolescentes para que en algún momento enviaran las fotos desnudos o en situaciones comprometedoras, el Deep Fake le permite al acosador ya tener en sus manos el elemento de coacción sin necesidad de haberse ganado la confianza de la víctima.

En pocas palabras, el mecanismo de Deep Fake -dentro del infinito universo de la Inteligencia Artificial- permite crear una imagen sintética hiperrealista, sin que deje de ser falsa.

Por esto mismo es que los especialistas advierten en la necesidad de, por un lado, avanzar en materia penal para imponer castigos duros a quienes recurran a la IA para generar Material de Abuso Sexual de Niños, Niñas y Adolescentes (MASNNA, erróneamente llamado “pornografía infantil”).

Pero, además, llaman a la sociedad a tomar los recaudos necesarios para intentar restringir al mínimo -en especial en adultos- la práctica de compartir en redes fotos de niños o adolescentes.

Esto es lo que se ha bautizado como Sharenting (un neologismo que parte de “share” -compartir en inglés- y “parents” -padres, también en inglés-).

“Es fundamental pensar como personas y como padres en la protección de la identidad, porque los mecanismos de control son escasos y es fundamental trabajar en la conciencia”, se explaya Navarro en diálogo con Los Andes.

Para el presidente de la red Grooming Latam, es clave que se considere a los niños, niñas y adolescentes como sujetos digitales, y que se los reconozca como rales, con sus derechos y responsabilidades.

“Debemos mensurar el peligroso impacto que la IA generativa comienza a tener en los patrones criminales de la pedofilia”, acota.

LA IA COMO GENERADORA DE PEDOFILIA

Hasta hace no mucho tiempo, la mayoría de extorsiones en un contexto de Grooming requería de toda una estrategia para lograr entablar confianza con el niño, la niña o el/la adolescente. Toda esta red era tendida por el criminal, quien -en redes sociales o sitios de juegos online-, creaba una identidad falsa y con la que se hacía pasar por un par de la víctima (otro niño, niña o adolescente).

A través de esta telaraña, el criminal conseguía convencer a la víctima para que ella enviara fotos sin ropa y en actitudes de intimidad. Claro que eso actuaba como una bola de nieve que va cayendo por la pendiente y ganando mayor tamaño, ya que -a partir de esa primera imagen-, el groomer extorsionaba y le pedía más y más fotos a los niños o niñas, y amenazaba con hacer públicas las primeras imágenes si la víctima se negaba.

Pero, de la mano de la IA (utilizada con estos fines delictivos), ahora ya ni siquiera se precisa ese trabajo delictivo previo para entrar en confianza y conseguir las primeras fotos para iniciar la extorsión. Porque se generan -o fabrican- con esta herramienta, entonces ya ni siquiera se precisa de una primera colaboración involuntaria de la víctima. Solo basta con una foto cualquiera para poner en práctica el ardid.

“Desde el punto de vista de las redes de pedofilia organizada en el mundo, se conocía el tráfico y la comercialización de MASNNA. Pero con la IA y el Deep Fake ya pasamos a hablar de un cambio de paradigma y que pasa de la producción hacia la programación, generación o fabricación de este material”, advierte Hernán Navarro.

“La producción de estas imágenes no solo tiene como objetivo el fomento de este material por parte de la pedofilia, sino que -además- estas imágenes se usan para entrenar a la IA mediante el “machine learning” (aprendizaje automático), lo que derivará en que se genere cada vez más contenido de este tipo”, insiste Navarro.

CASOS CONCRETOS

A los episodios ya descriptos en Buenos Aires -y sobre los que la Justicia ya está trabajando-, se suman otros tantos de los que se ha tenido conocimiento en España.

Y el peligro no está solamente en la generación de imágenes apócrifas tomando como punto de partida el rostro de una persona cualquiera en una fotografía pre existente cualquiera -de hecho, los parámetros reales del rostro en una de estas imágenes se tomaron de la foto de un inocente festejo de cumpleaños-, sino en la invención de perfiles.

Antes del boom de la Inteligencia Artificial, cuando un groomer comenzaba a chatear con un potencial víctima, necesitaba tener a mano alguna foto genérica a mano para enviarle a su presa si ella quería cerciorarse de que estaba chateando con otro niño, niña o adolescente de su edad. Esto implicaba, entonces, tener una foto ya elegida.

Pero ahora, dentro de las posibilidades de la IA, el delincuente puede crear la foto de la persona que quiera ser, con la apariencia que prefiera y simplemente darle las indicaciones exactas. Incluso, hasta puede “vestirse” como lo desee y posar en el paisaje que elija.

Una ONG argentina creó la primera red latina de lucha contra el acoso sexual a niños en internet en el mundo

“La Inteligencia Artificial es funcional a la creación de perfiles apócrifos. Sabemos que la pedofilia emplea este mecanismo camaleónico de cambiar de perfil -o generarlo- para acceder a vida del niño, niña o adolescente. Y, mediante la IA, ese perfil se va a poder ajustar a las particularidades y a las necesidades que se detecten y donde la víctima sea vulnerable”, describe el abogado.

CÓMO PREVENIR

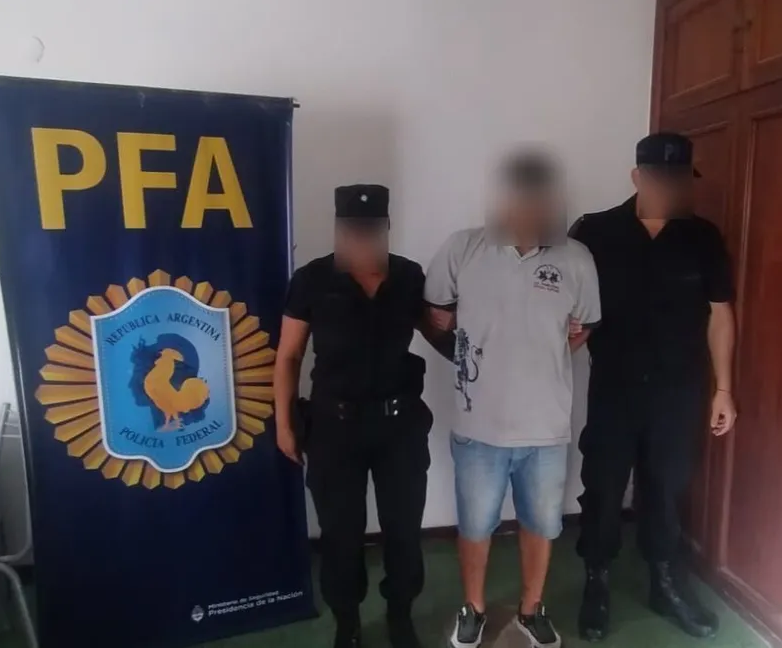

En Argentina, episodios como el ya mencionado de la adolescente bonaerense -por ejemplo- constituyen un delito penal. Esto es porque se está utilizado un rostro real para generar la imagen de desnudo, que se completa con Deep Fake.

Según explica Navarro, la Justicia argentina tiene las herramientas disponibles para avanzar en estos hechos acorde el artículo 128 del Código Procesal Penal, justamente, porque el rostro se ajusta a una persona real.

No obstante, para el presidente de Grooming Latam urge además avanzar en material regulativa en los casos de las imágenes de MASNNA creadas íntegramente por la Inteligencia Artificial.

“Existe una anomia, por lo que no técnicamente no se considera delito en aquellos casos donde las imágenes de MASNNA son completamente ficticias y no existen niños reales. Pero se debería avanzar en esto, como ya se ha hecho en el Reino Unido y Estados Unidos”, reflexiona Navarro,

Para el abogado especializado en el tema, es fundamental que en Argentina se contemplen como delito los casos de imágenes de niños, niñas o adolescentes víctimas de explotación sexual y que hayan sido íntegramente creadas por la Inteligencia Artificial.

“Una pseudo imagen generada por IA que refleje violencia sexual a niños, niñas y adolescentes debería ser considerada real. Y tanto su posesión como publicación o transferencia son ilegales”, sintetiza.

Los Andes

-

#Escuchá La 97.1 todo el día, hacé click acá📻

#Descarga la App de #RTuc haciendo click acá📲

-

Seguinos

+543816909015